共计 3084 个字符,预计需要花费 8 分钟才能阅读完成。

前两周小红书刚在欧美媒体掀起滔天巨浪,这几天 DeepSeek 又向全球 AI 圈丢了一颗炸弹。

前两天提到软银孙正义和美国几家 AI 巨头准备投资 5000 亿美元打造星门计划,试图保持对其他国家在 AI 领域的绝对优势时,提到会出一篇介绍“国产之光” DeepSeek 的文章。

今天,它来了!

作为 ChatGPT 出世后就重度使用各种 AI 大模型的人,中美两国主流的大模型我基本都使用过了。目前仍在付费使用的只有 GPT-4o/o1、Claude 3.5 Sonnet,现在又加上了一个 Deepseek R1。

至于 Kimi、文心一言、通义、豆包等等,已经卸载了。

抱歉,不是你们不够好,是 DeepSeek 更具性价比。

是的,你们离 GPT-4o 和 Claude 3.5 Sonnet 确实还有些距离。。。

有人可能觉得我为了流量而故意吹牛。

哈哈,还真没有。

大家可以看看昨天《纽约时报》的文章是对 DeepSeek 的介绍。

或者看看《经济学人》今天的报道 《中国 AI 正在迎头赶上,给特朗普带来两难困境》。

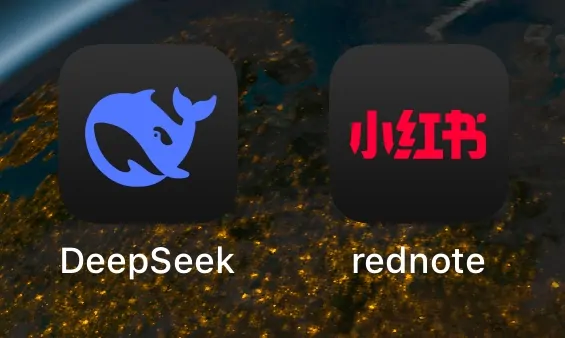

在上个月 DeepSeek 发布 V3 后,我看到 Reddit 上有发帖说自己对比测试了下 DeepSeek V3, Claude 3.5 Sonnet 和 GPT-4o,结果让他吃惊,如下:

- 推理:DeepSeek V3 > Claude 3.5 Sonnet > GPT-4o

- 数学:DeepSeek V3 > Claude 3.5 Sonnet > GPT-4o

- 代码:Claude 3.5 Sonnet > DeepSeek V3 ~> GPT-4o

- 写作:Claude 3.5 Sonnet > DeepSeek V3 ~ GPT-4o

要知道,DeepSeek V3 的价格才是 GPT-4o 和 Claude 3.5 Sonnet 的几十分之一。

当时我也测试使用 DeepSeek V3 来帮助写作和编程了,效果虽然不错,但还没让我心动到替换 Claude 3.5 Sonnet 的地步。

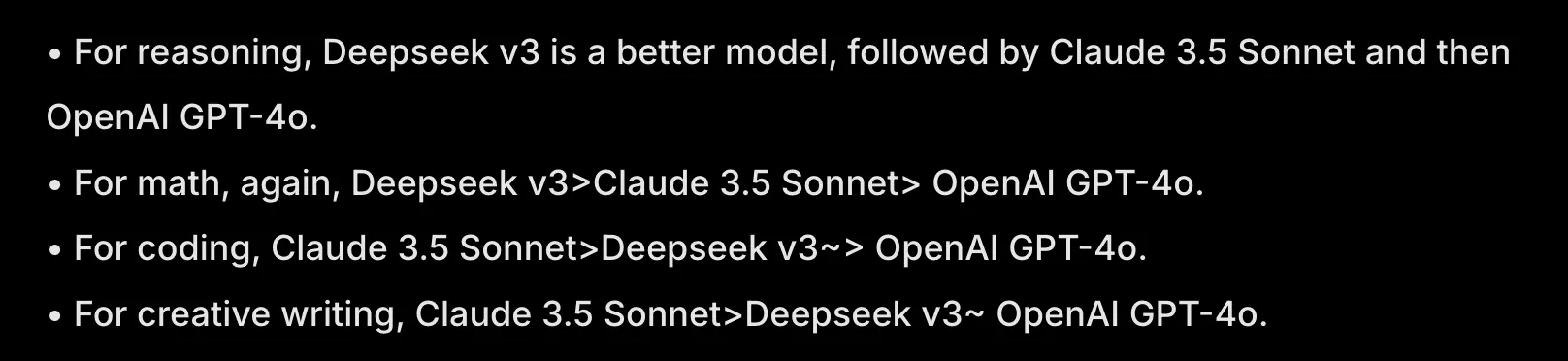

前几天 DeepSeek 发布 R1,我注意到有人在花式称赞它:没有华丽的演示,没有夸张的承诺,也没有大肆宣传,但用过的人都说好。

也有人使用 DeepSeek R1 和 ChatGPT o1 Pro 对比编程效果,要求实现一个旋转的三角形内有一个红球,测试下来 DeepSeek R1 的效果符合预期:

(左边是 ChatGPT o1 Pro,右边是 DeepSeek R1)

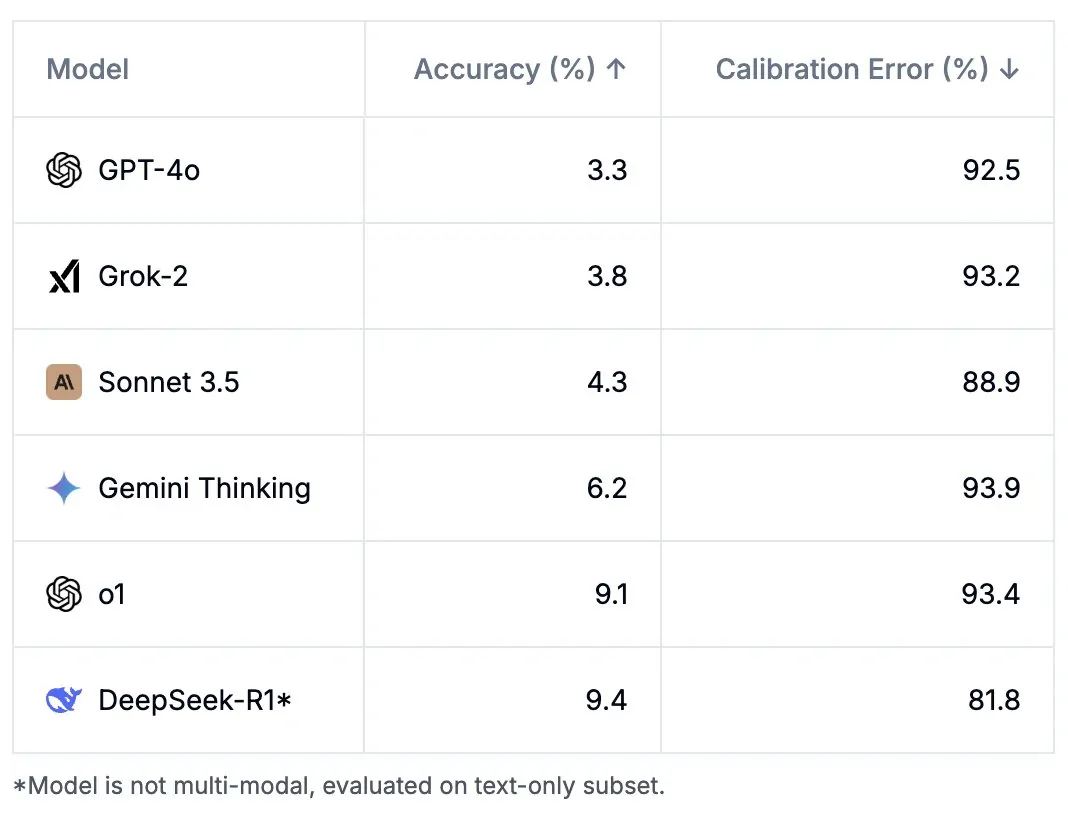

然后又有人使用 Humanity’s Last Exam(“人类最后的考试”,包括数学、编码、物理、化学、法律等一系列科学,主要是为了评估模型在跨学科专家级推理上的能力)测试主流模型。

结果 DeepSeek 的表现又是最好的。

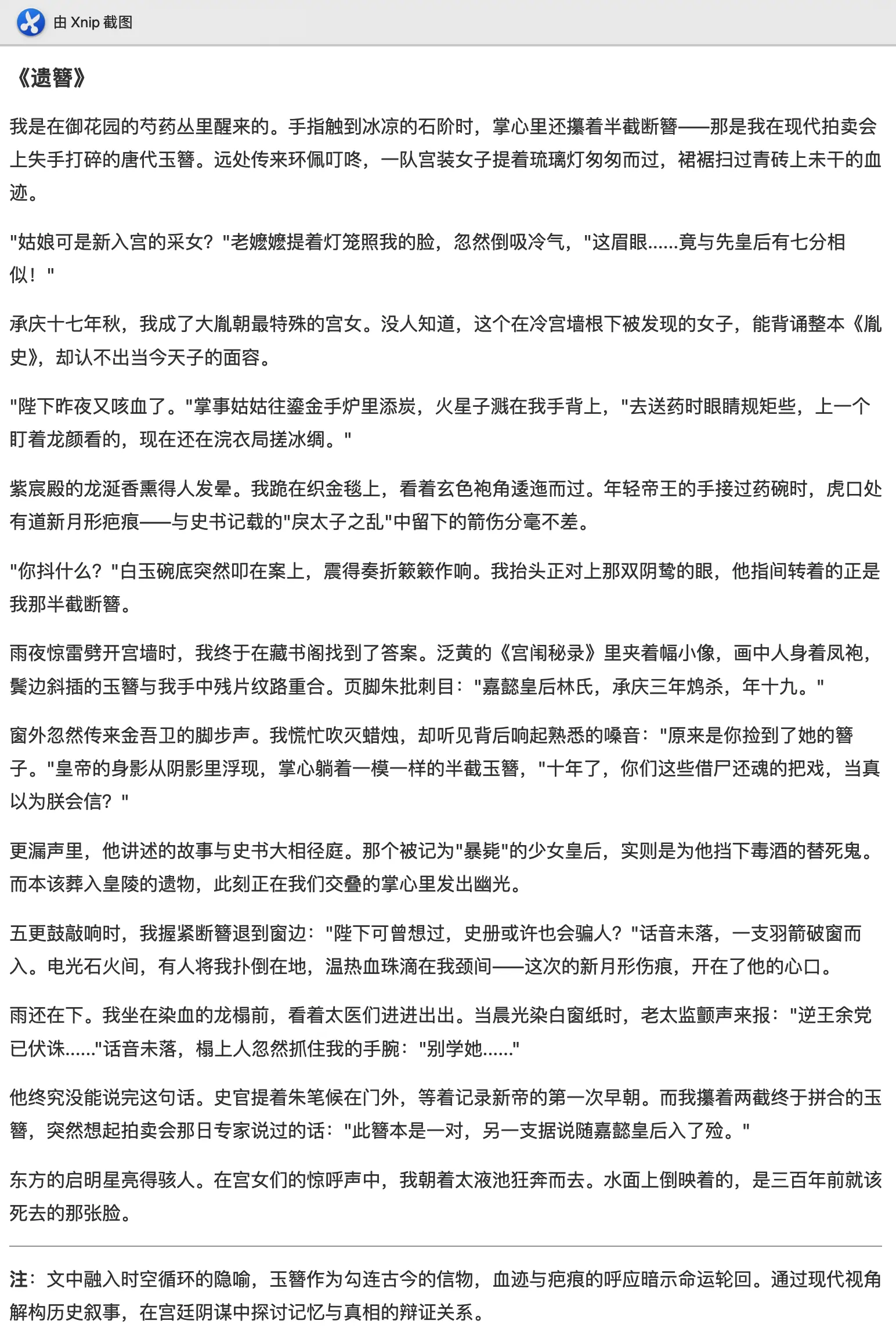

好奇之下我又打开 DeepSeek,使用“深度思考”模式让他写个穿越小说。这次确实惊到我了。

这文字不比知乎盐选付费的文章好???

当然,在老外们“感到恐慌”时,很多国人仍不相信国内能搞出靠谱的东西。

我看到有不少人称:自己永远也不会相信,国内能搞出真正靠谱的东西,当年的龙芯,现在的 AI,都是叙事,都是出口内销,骗补贴而已,不要太当真。

说实话,你要是问我 DeepSeek 是不是最先进的?那肯定也不是,他的综合实力离 GPT 4o/o1 还有些差距,但目前看起来并不大。

你要说 DeepSeek 是不是有内容审核?的确也有。但做为一个开源模型,自己喂一些数据集也能解决这个问题吧。

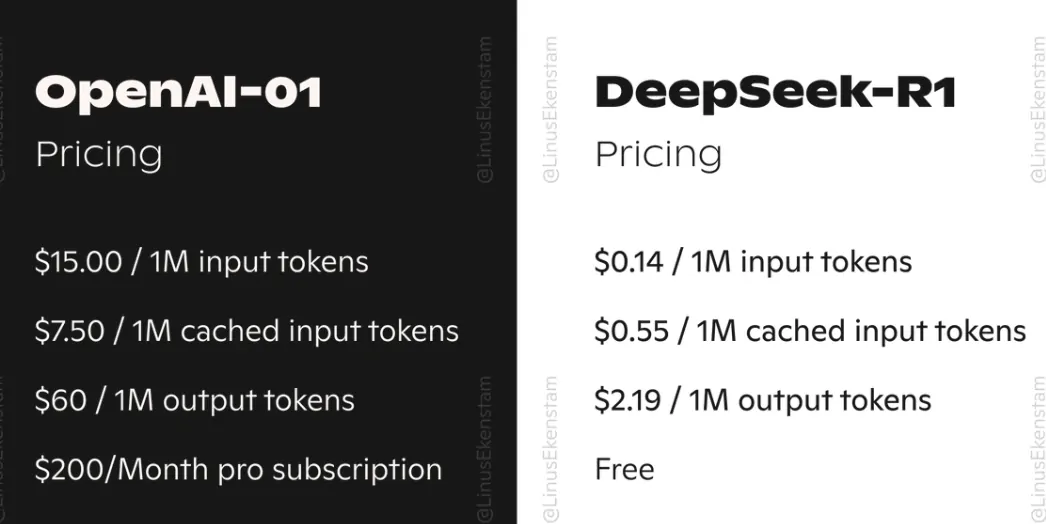

不过你再想一想,DeepSeek R1 以 OpenAI 几十分之一的价格,却实现了差不多的交付水准。

真的,不是我说,还要啥自行车啊。

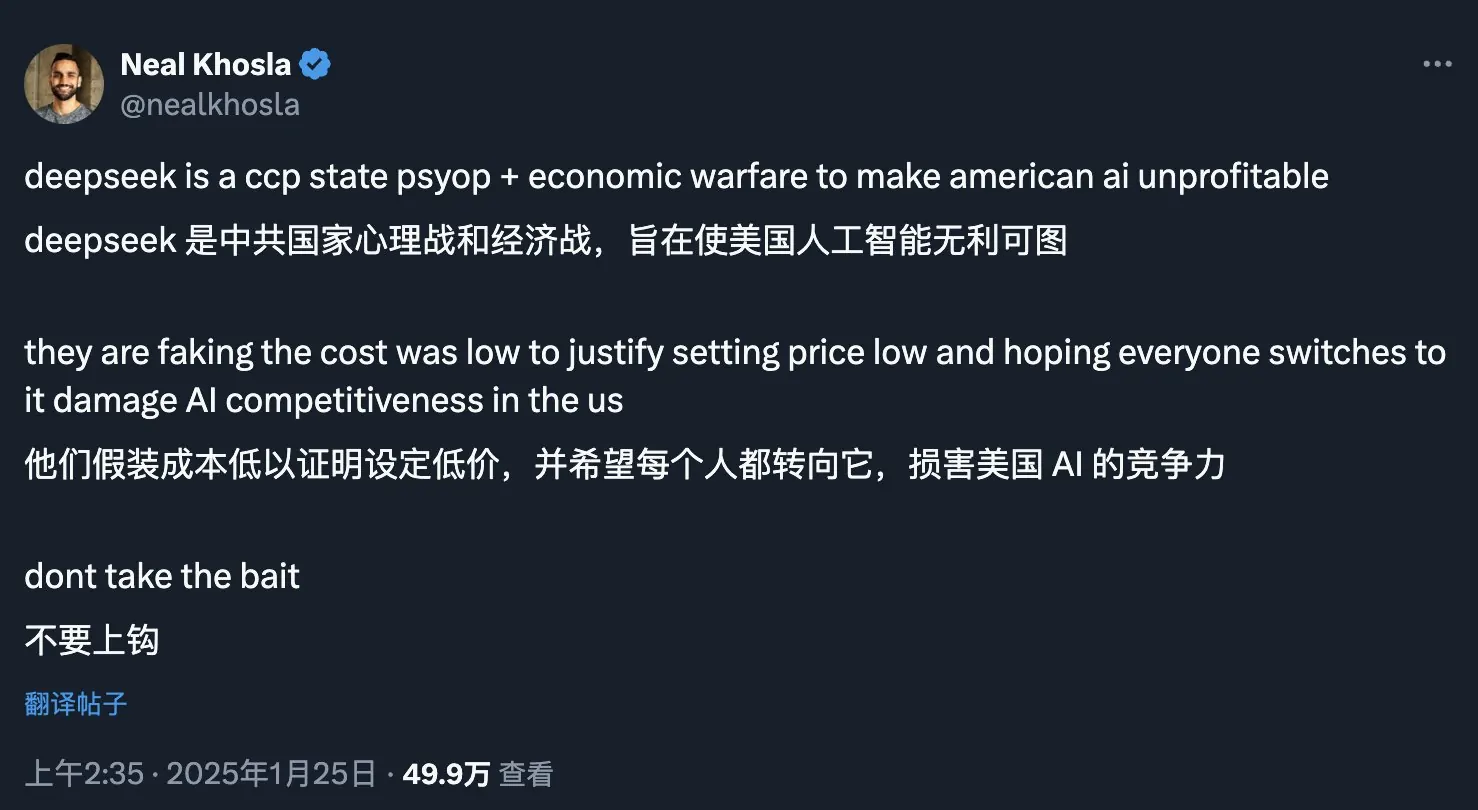

你看,今天就有老外怀疑 DeepSeek 故意把价格定的这么低,就是为了打击美国人的心理和经济,降低 OpenAI 的利润。他还号召大家不要上钩。😂

很多人应该会好奇,DeepSeek 这么便宜,他是怎么赚钱的?

首先,DeepSeek 是幻方量化的子公司,幻方量化这两年靠量化交易在 A 股赚了很多很多钱,所以这家公司并不差钱。。

在此,感谢下 A 股股民。(看了眼自己的账户,我谢谢我自己 😭)

其次,得益于 DeekSeek 的训练方式与一般大模型不同,目前也缺少识别图片等功能,致使其无论是数据集还是成本都少很多。

所以 DeepSeek 并不像其他 AI 巨头一样在亏本烧钱,他从去年就在盈利了。

国外 AI 巨头的反应#

DeepSeek 作为开源项目,直接竞争对手是 Meta 的 Llama。

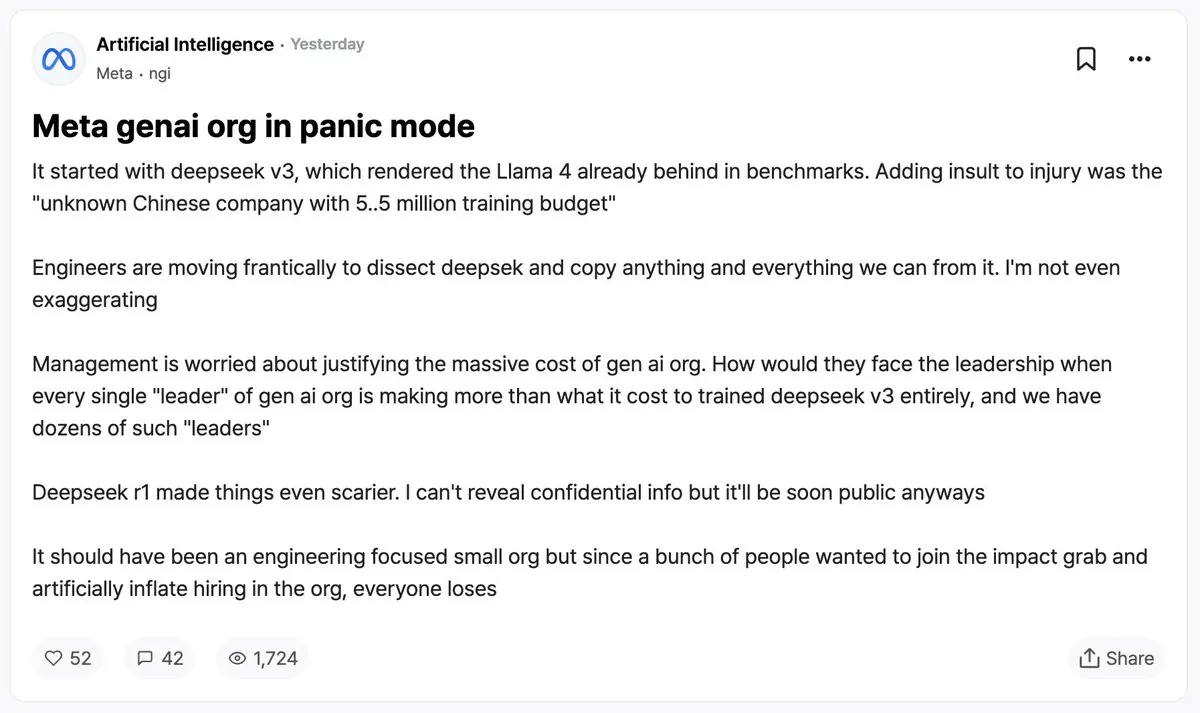

而昨天 Meta 的 AI 团队有人匿名发帖,声称 Meta 的生成式 AI 团队陷入了恐慌状态。

该帖称 DeepSeek V3 的推出已经让 Llama 4 在各项基准测试中全面落后,现在又推出了 R1,更让人害怕。

雪上加霜的是,这家“未知的中国公司”仅用 550 万美元的预算完成了训练!这比他们团队每一个领导的工资都要少,而这样的“领导”在团队中有数十人之多。整的他们已经不知道如何看到领导了。🤣

看过前一篇文章的小伙伴也知道,扎克伯格确实认为 DeepSeek 非常先进,他还呼吁美国加紧封锁。

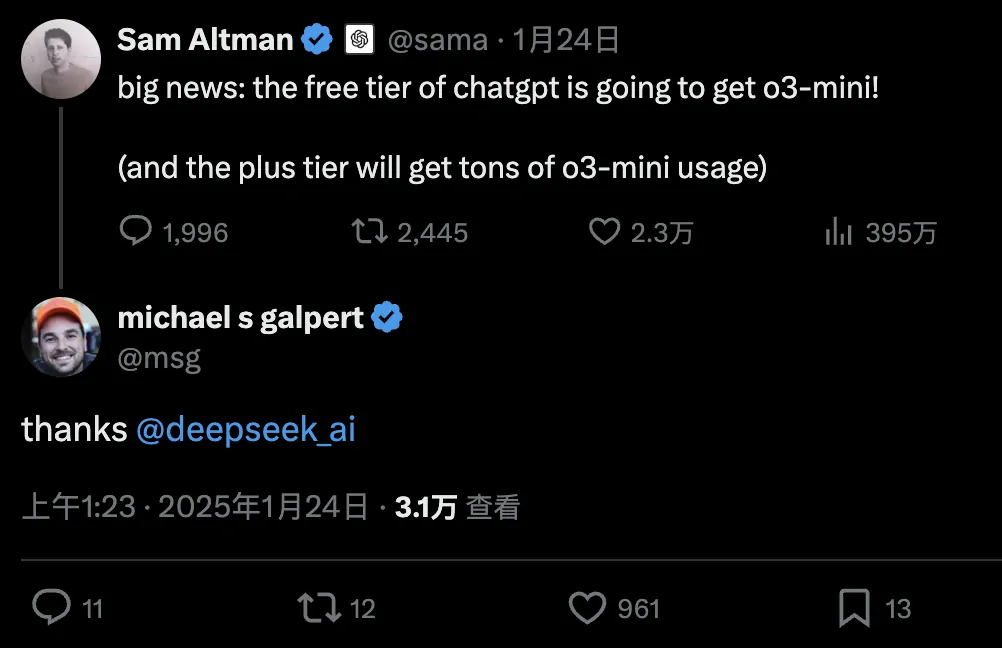

作为生成式 AI 总龙头,OpenAI 又是如何做的呢?

昨天,山姆 · 奥特曼直接宣布 GPT o3-mini 免费!老外们纷纷感谢 DeepSeek 的 “灵魂砍价”。 🤣

是的,你可以不使用 DeepSeek,但是你要感谢 DeepSeek。

A16z 创始人安德森则表示,DeepSeek R1 是送给世界的礼物,并表示本周可能是十年来最重要的一周。

A16z 的合伙人 Anjney Midha 也提到:“从斯坦福到麻省理工,DeepSeek R1 一夜之间成为美国顶尖大学研究人员的首选模型”。

开源或许才是中国追赶美国的希望#

正如新能源汽车一样,AI 领域也只剩下中美两个国家在竞争了。

欧洲日本连我们的车尾灯也看不到了。

虽有 DeepSeek 这一波搅局,但现在 AI 领域综合来说,还是美国断档领先,手握硬件软件两大杀器号令天下。

再加上川普一上台就大力推动“星门计划”,美国 AI 技术的发展将越走越快。

好在我们并没有落后太远。

正如今天《经济学人》文章中提到的一样,“去年,我们(指美国)在 AI 领域的领先优势看似不可逾越,但现在就没那么大了。另外,如果你看一下技术人才因政治原因龟缩美国的情况,你就会发现目前的长期预测并不乐观。特朗普的 5000 亿基金很可能是国家生存所必需的。看看大多数顶级科技职位。许多顶级创新者都是中国人,他们的文章都是用普通话写的。”

那为什么我认为 DeepSeek 的开源路线很可能是国内 AI 大模型突破美国封锁的希望呢?

大家还记得去年李彦宏说“开源大模型不如闭源,后者会持续领先”吧。

从当时状态看,闭源领先开源是毫无疑问的,所以李彦宏核心论断之一就是,无论中美,最强基础模型都是闭源的。

但闭源能够领先的原因,其实和芯片一样,都是美国刻意对我国的封锁。

众所周知,中文大模型落后的两大原因,一个是缺少高端芯片,另一个就是高质量的中文语料太少了。

DeepSeek 老板梁文峰在接受采访时也提到了这个问题。

不过以 DeepSeek R1 现在的影响来看,以后肯定会吸引不少世界顶级 AI 人才去参与训练、优化它。

你掏出你的 H100 优化优化参数,我掏出我的 A100 跑一跑模型。

DeepSeek 的开源解法没准还真能突破美国对我国芯片的的封锁,甚至在一定程度上弥补语料质量差的问题。

正如开源 Linux 和闭源 Windows 的竞争一样,你 Windows 在桌面市场占据统治地位,我 Linux 在服务器市场也是无人能敌。

未来我们可能生活在这样一个时代:一家非美国公司正让 OpenAI 的初衷得以延续 — 真正开放的为所有人赋能的前沿研究。

如今,随着 DeepSeek 用开源代码和白菜价格,在硅谷的镀金神殿里劈开一道裂缝。

我们有幸见证着一场无声革命:当技术霸权遭遇平民化颠覆,当“算法贵族”被“代码民兵”围剿 — 这场 AI 战争没有硝烟,却可能比芯片制裁更深刻地重塑世界秩序。