共计 1686 个字符,预计需要花费 5 分钟才能阅读完成。

老外们这两天开始担心英伟达的股价要暴跌了。。。

我们之前聊了下现在美国科技界对 DeepSeek 的看法,并提到个人拙见:开源或许才是我国突破美国封锁的唯一办法。

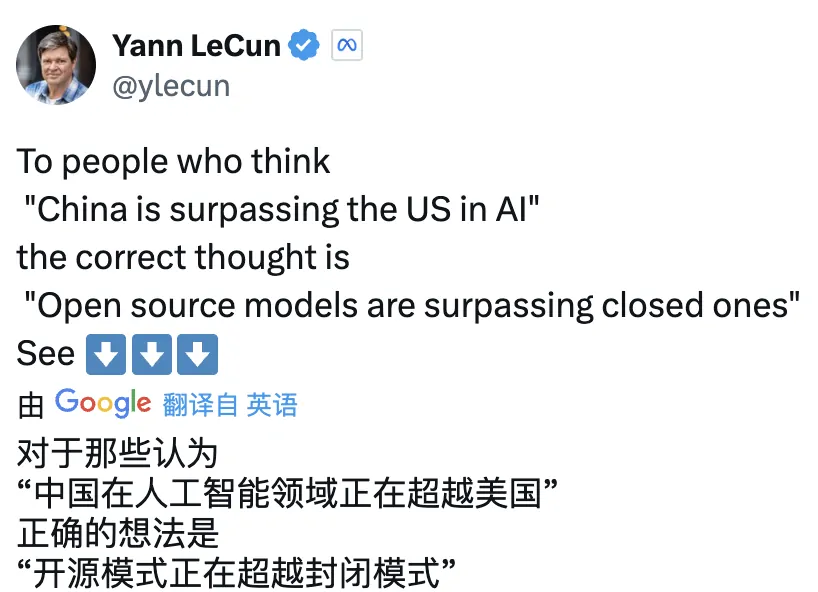

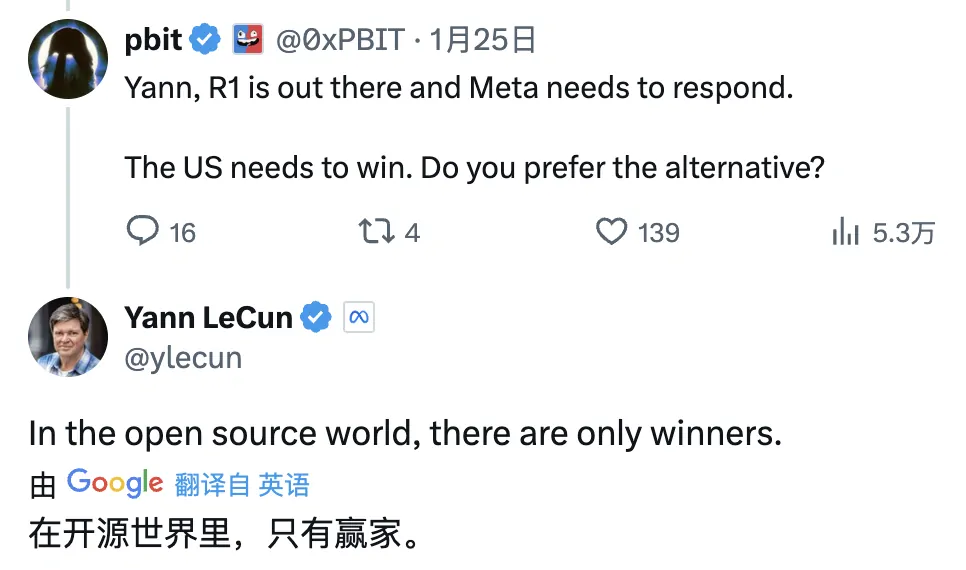

然后就看到卷积神经网络之父、Meta 首席人工智能科学家杨立昆也表达了对开源的积极看法。

他认为,在看到 DeepSeek 表现后就认为中国在 AI 方面正在超越美国的解读是错误的。正确的解读应该是开源模型正在超越闭源模型。DeepSeek 得益于开源研究和开源项目,如 PyTorch 和 Llama,是在他人工作的基础上提出了新想法并进行了构建。

在有人提到“美国需要胜利,Meta 需要回应”后,杨立昆则表示 “开源世界没有输家”。

一个真“帮家人们把价格打下去”的模型,竟然还开源,以后岂不是遍地“小”模型了?

要知道,DeepSeek 用 2000 多张 H800 GPU(不到 2000 万美元),花了 500 万美元训练数据,就得到了堪比 GPT 4o 的 R1 模型。如果打败 OpenAI 仅需要 3000 多万美元,那美国几大 AI 巨头花几千亿美元买英伟达的 GPU 还有什么意义?

哎,真别说,搁我我心里也犯嘀咕。这波 DeepSeek 不会真要把英伟达的泡沫给戳破吧?

你看,AMD 已经决定将 DeepSeek V3 集成到自己家的 GPU 上了。

但我认为 DeepSeek 并不会影响英伟达的股价。

为什么这么说呢?

我说下我的分析,不一定对,各位姑且听之看之,有不同意见也欢迎在评论区留言讨论。

大公司的目标是领先优势#

相对于主流推理模型需要大量训练数据而言,DeepSeek R1 通过纯粹的强化学习(后文简称为 RL)大大降低了成本。

这种方式正是 9 年前 AlphaGo 的训练方式:通过玩无数场围棋游戏,使用纯 RL 最大化奖励函数(赢得比赛),最终 AlphaGo 击败了李世石。

DeepSeek 其实是开创了一条低成本训练 LLM(大语言模型)的路线,降低了 LLM 的门槛,给更多人一个参与机会。

但不管是 OpenAI、Google 或者 Meta,他们手上并不差钱。他们的首要目标是领先优势,而非优化成本。他们不仅追求对其他公司的领先地位,也追求对其他国家的领先地方,尤其是我国。也正是这个目的,所以美国宣布要用 5000 亿美元推动“星门计划”,要打造人类最强的人工智能基础设施。

这些巨头也许会试着使用 DeepSeek 的方法去优化部分成本,但这条路不会是他们的主要方向。

总之,DeepSeek 的成功并不能说明 OpenAI 堆算力的方案就是错的。

大语言模型还有很大上升空间#

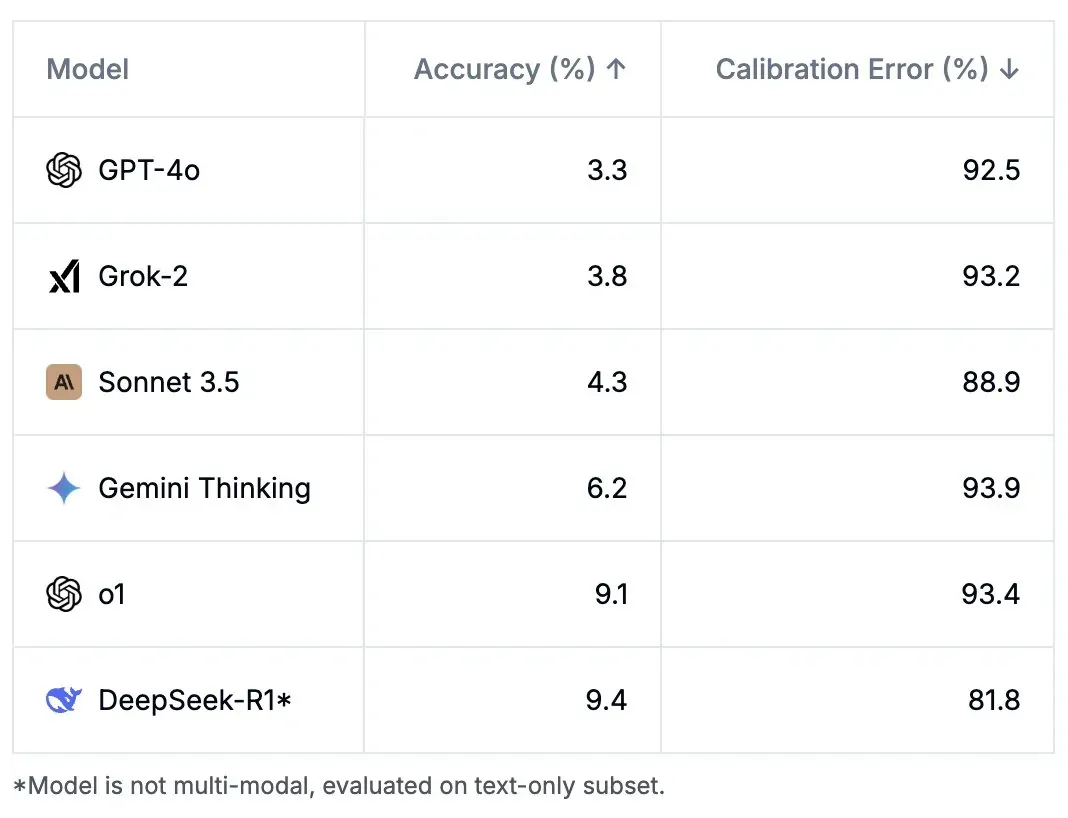

在前文中我曾提到,使用 Humanity’s Last Exam(即“人类最后的考试”)来测试这些模型,准确率均不超过 10%。

也就是说,现阶段各家的 LLM 还有很长的一段路要走,这仍需要大量算力。即使未来 LLM 算力饱和,也可能还有其他形式的 MLs 需要算力。

算力如同能源一样,哪里都需要它。

并且 DeepSeek 目前只是文字处理能力惊艳,对图片的处理能力很弱,目前只有 OCR 能力。而据网友测试, GPT 4o 和 Gemini 能识别出图片想表达的意思。豆包也有能力生成图片,虽然目前还不太好用。

也就是说,DeepSeek 想要变的更强,也需要更多的卡去训练学习,来满足更多需求。

DeepSeek 或能引爆小企业需求#

上面说 DeepSeek 的路线大大降低了 LLM 的门槛。这将驱使更多小公司或个人训练私有模型。

如果说去年 ChatGPT 横空出世,被很多人誉为 AI 进入 “iPhone 时刻”。那么如今 DeepSeek 的开源就是 AI 进入 “安卓时刻” 了。很多公司会在 DeepSeek 的方案上“百花齐放”。

比如声称要“让印度再次伟大”的 Perplexity CEO 就称自己将投入更多资金去参与 AI 领域的竞争。

如果能引发大量中小型企业、家庭和个人用户对推理的“第二波”需求,那么这些增量将远超过 AI 巨头减少买的 GPU 量。

就像个人电脑从一台 2 万美元降到 2 千美元后,微软反而迎来了更快的发展。

总之,DeepSeek R1 的突破确实挑战了主流大模型的研发模式,其对英伟达的影响也许更多只是停留在短期的市场情绪层面。

截止目前,英伟达的股价为 142.620 美元。

我们可以拭目以待这几天英伟达的股价走势。