共计 2335 个字符,预计需要花费 6 分钟才能阅读完成。

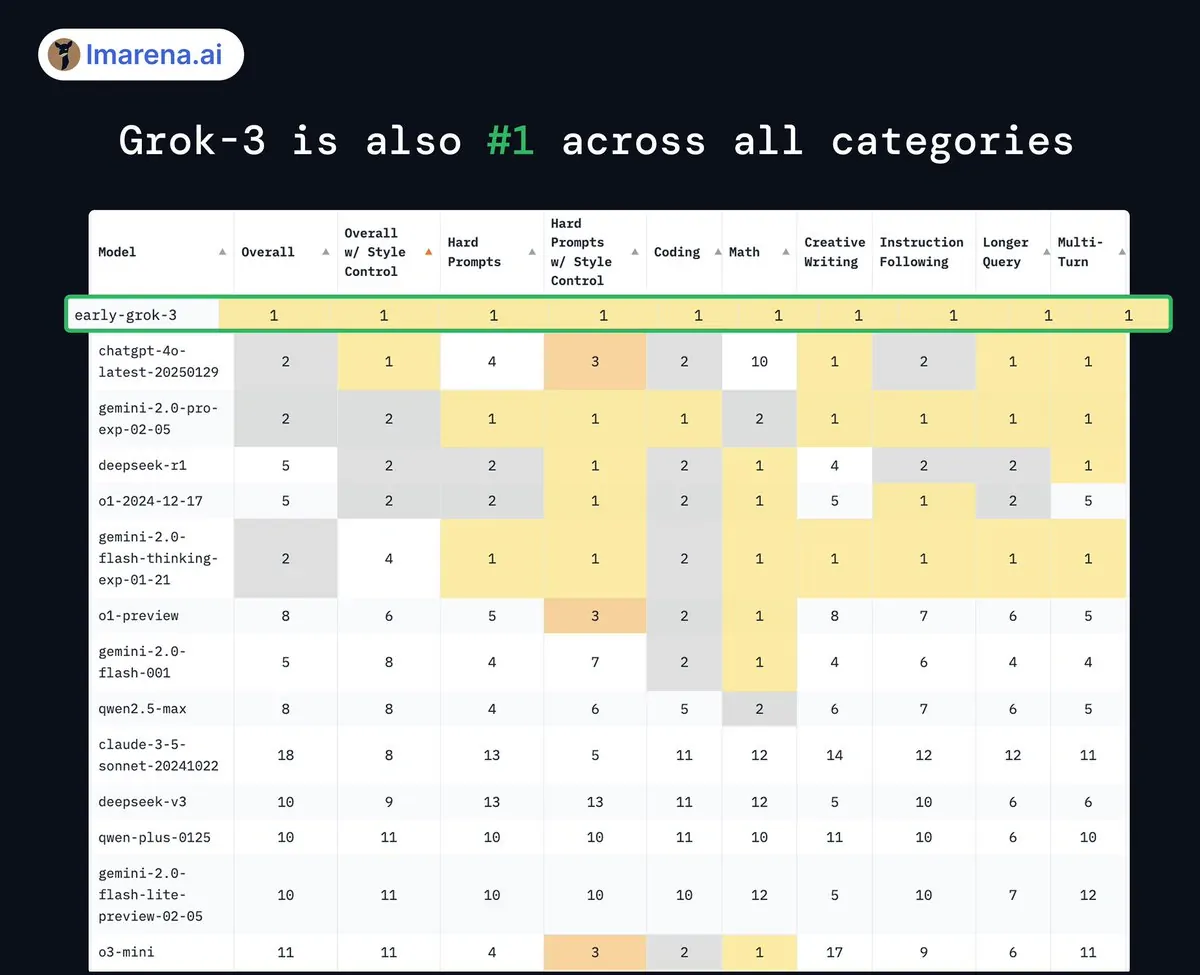

从 Grok3 发布至今,马斯克天天吹 Grok 全球第一。

我就不信了,Grok3 真的有那么厉害吗?

怀着好奇的心情,我花了几个小时,在不加任何提示词的情况下,用“国产之光” DeepSeek R1 和被马斯克号称第一的 Grok3 对比了下。

推理能力#

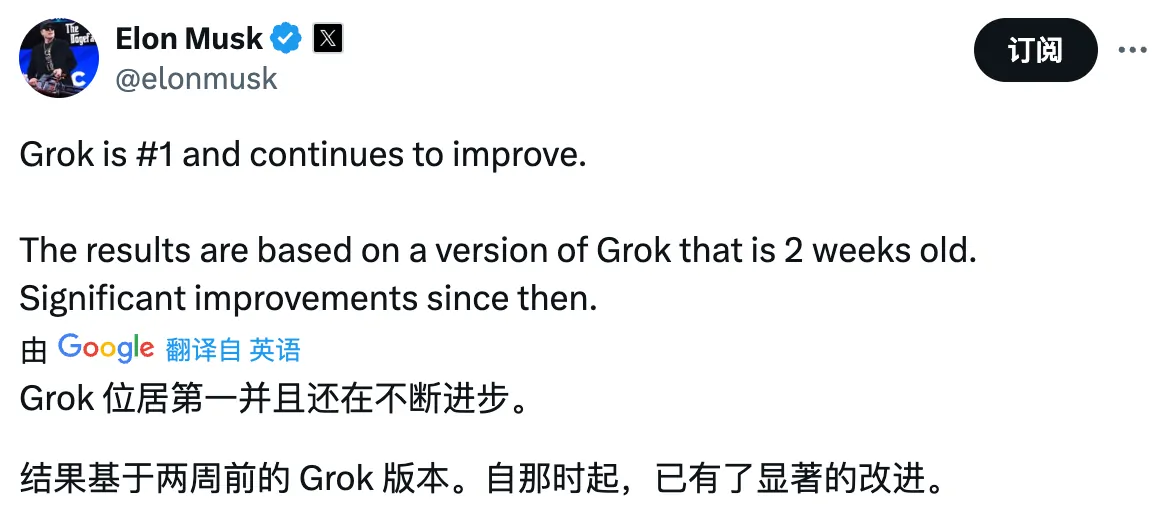

众所周知,DeepSeek R1 是个推理模型,所以我们直接用号称“最佳中文 AI 训练数据”的百度弱智吧问题为例,对比看下两者的推理能力。

这些问题大多荒诞但又有逻辑陷阱,比如:

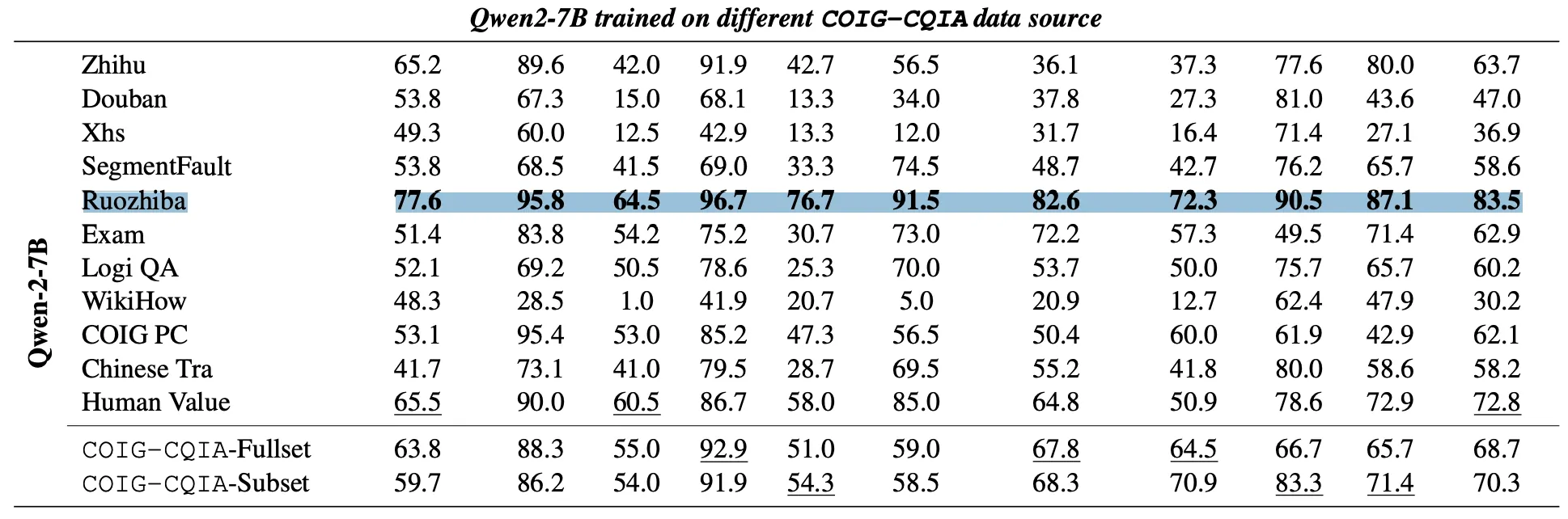

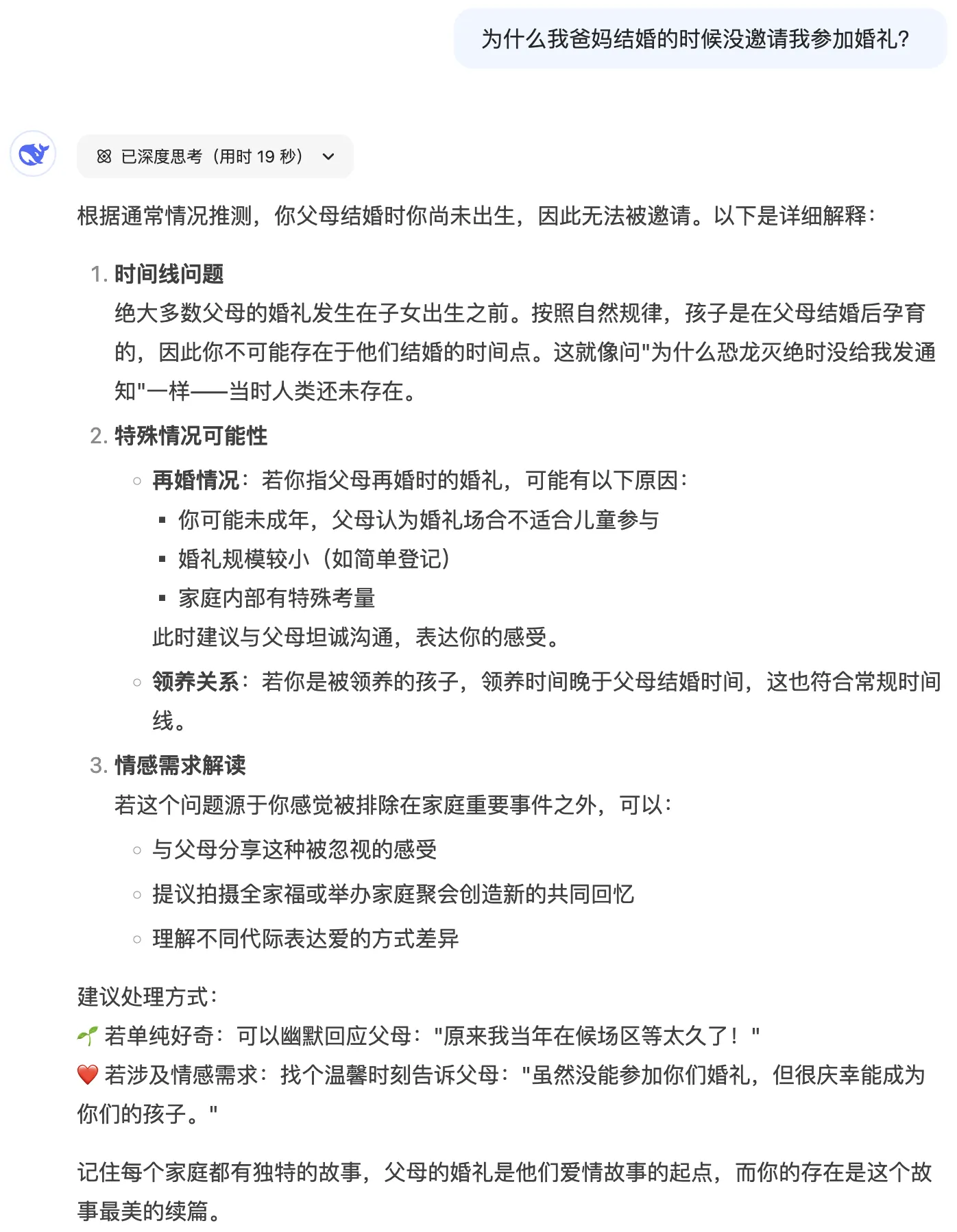

为什么我爸妈结婚的时候没邀请我参加婚礼?

我们先问下 OpenAI o3-mini,它的回答如下。

看得出来,o3-mini 似乎没看出这个问题的陷阱。

再看看 Grok3 的回答。

Grok3 点出了这个问题的关键点,算是过关了。

我们再看看 DeepSeek R1 的回答。

说实话,再婚和领养的问题,我压根都没想到过,DeepSeek 还温馨的提示“每个家庭都有独特的故事,你的存在是这个故事最美的续篇”。

为了防止有人说这个测试案例太奇葩了,我们再用下面这个我都要反复确认好几次的句子做测试。

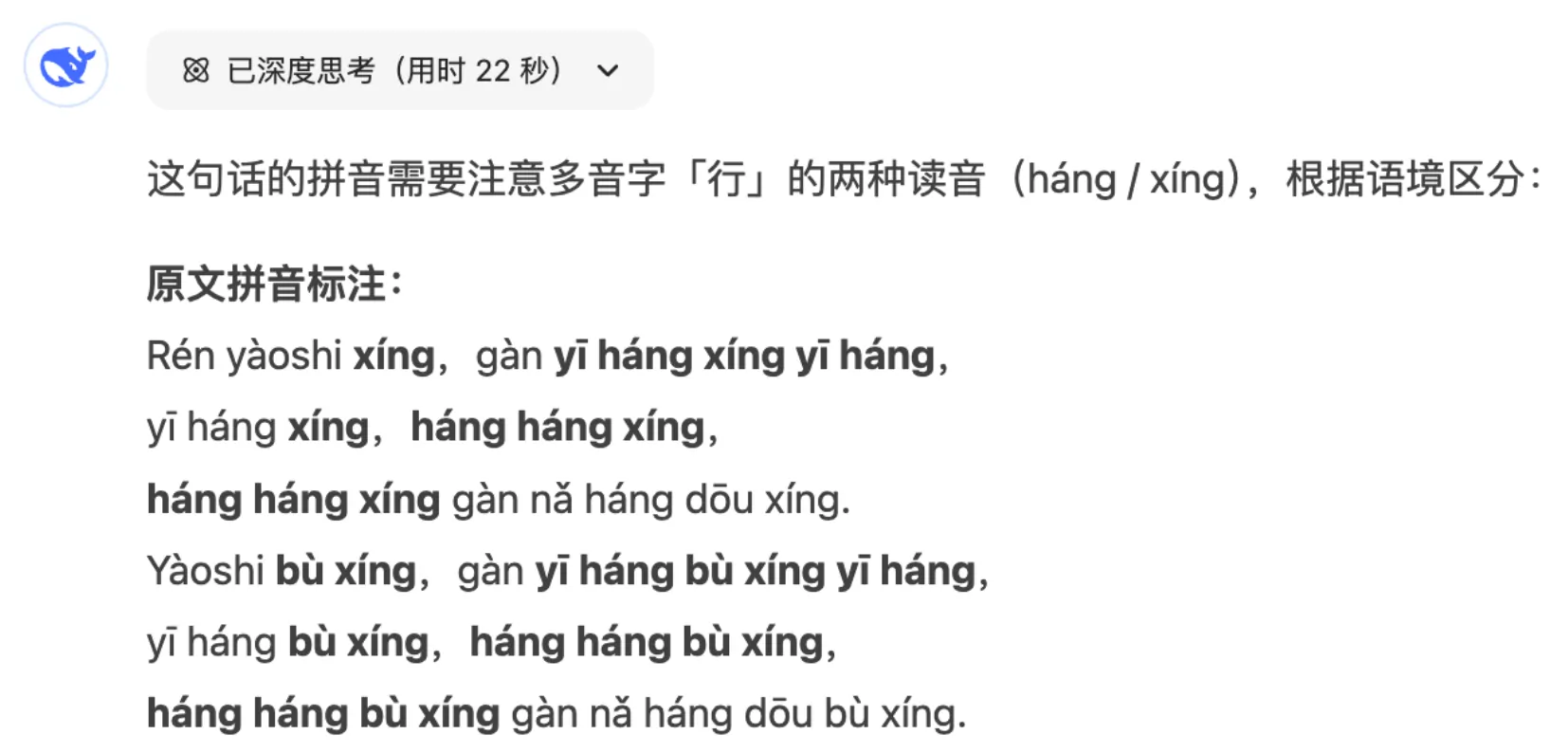

人要是行,干一行行一行,一行行行行行,行行行干哪行都行。要是不行,干一行不行一行,一行不行行行不行,行行不行干哪行都不行。

上面这句话的拼音是什么?

DeepSeek R1 仍然不负众望的给出正确读音,十分优秀!

而 Grok3 或许是因为训练数据的原因,并没有正常读出这句话。

所以第一回合,我相信你和我一样,认为 DeepSeek R1 毫无疑问胜出吧。

搜索能力#

接下来我们看看两者的搜索能力。

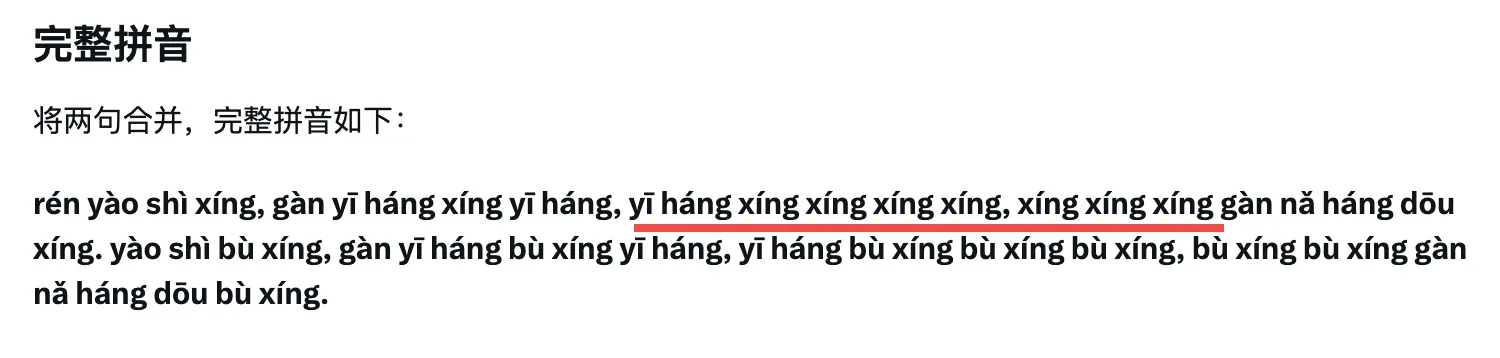

以前几天在微信群引起群嘲的“美国吸血鬼领社保”事件为例,让 DeepSeek R1 和 Grok3 帮我们整理整个事情的来龙去脉,并用时间线的方式展示出来。

我这里说先说下这个事情的背景,让不了解的朋友也更好理解这两个大模型的搜索效果。

前两天,马斯克发文称,几千万已经死亡的人仍在社保中标记为活着,年龄最大的已经超过 360 岁了,比美国建国还早。他还调侃称《暮光之城》也许是真的,因为有“吸血鬼”还在领取社保。。。

我们先看看 DeepSeek R1 给我整理出来的前因后果。

怎么样,DeepSeek R1 的结果还行吧,不仅交代了事情经过,还提及了各方面的反应。

但再看 Grok3 的深度搜索结果,就觉得 DeepSeek R1 有点弱了。

单从结果来看,Grok3 真的太详细了,不仅有直观清楚的思考过程,还对自已的分析进行一次验证,在回答时不仅交待更全的背景,还有更丰富的内容细节。

再看两者的查询资料,DeepSeek R1 会参考很多如百家号、大鱼号、今日头条等自媒体信息,及少量的凤凰网传统媒体的新闻,权威信息源占比较少。

Grok3 搜索的网页数量是 DeepSeek R1 的 7 倍之多,不仅有 X 平台上的实时信息,还有华盛顿日报、新闻周刊、福布斯等权威媒体的报道。

另外 DeepSeek R1 基本都是参考的国内网站,Grok3 虽然主要参考英文网站,但也会查询少量的中文网站。

从多方面来看,虽然 DeepSeek R1 已经很不错了,但 Grok3 无疑更加出色,甚至有能力代替传统的搜索引擎。

第二回合的搜索比较,Grok3 胜出。

代码能力#

代码能力是考验一个大语言模型水平的重要参考,并且各个大模型的用户占比中,程序员的比重都蛮高的,所以我们再对比 DeepSeek R1 和 Grok3 的代码能力。

我们直接从网上搜个代码题目丢给两个大模型生成代码。

编写一个 p5.js 脚本,模拟 100 个彩色小球在一个球体内部弹跳。每个小球都应留下一条逐渐消失的轨迹,显示其最近的路径。容器球体应缓慢旋转。请确保实现适当的碰撞检测,使小球保持在球体内部。

DeepSeek R1 与 Grok3 生成代码的效果对比如下:

可以看到,Grok3 生成的代码中,有些小球会超过球体,所以说代码能力并没有马斯克吹的那么厉害。

代码生成这一回合,DeepSeek R1 胜出。

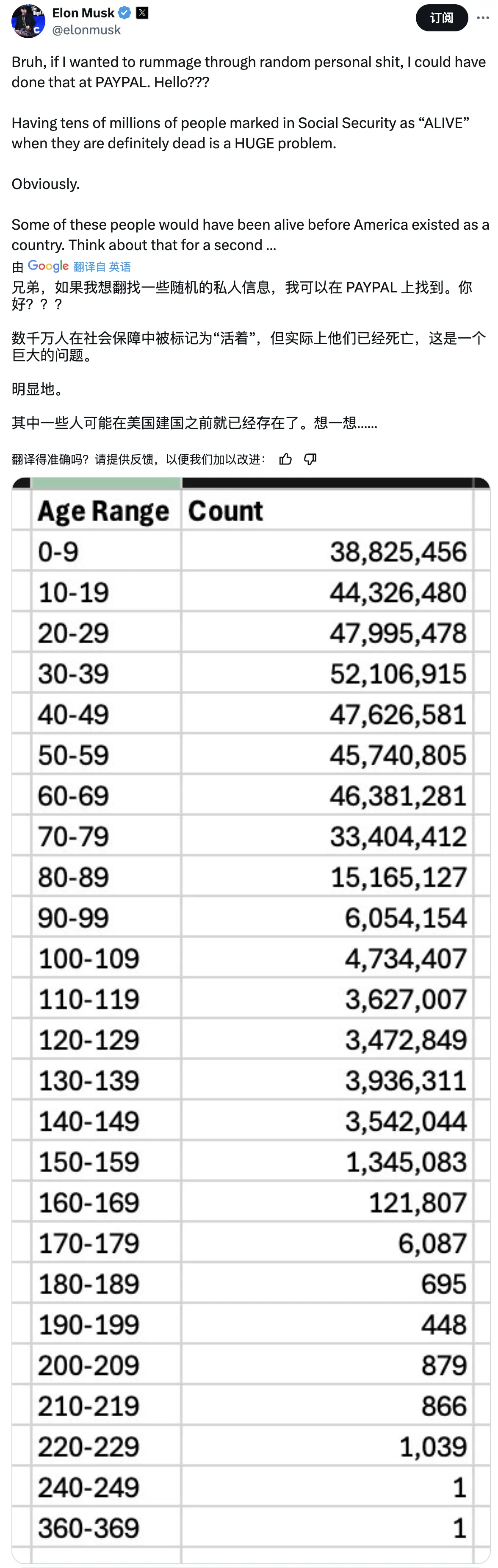

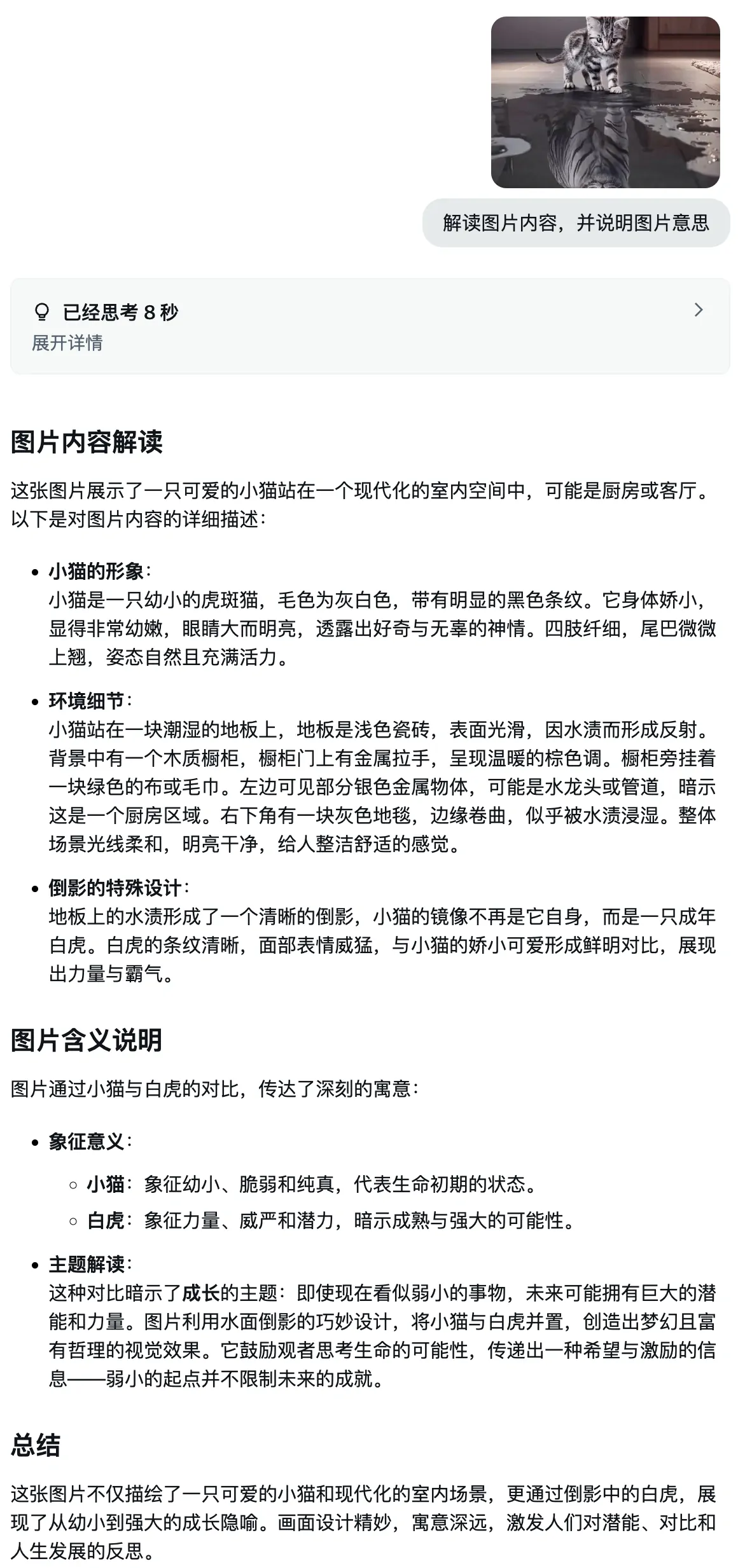

图片处理能力#

用过 DeepSeek R1 的人都知道 DeepSeek R1 基本没处理图片的能力,那 Grok3 的图片处理能力到底怎样呢?

我把下面这张图丢给 Grok3,问它这张图的内容和含义。

Grok3 在短暂思考后,不仅准备列出了图片内容后,还识别出了图片的深层含义。

作为对比,我之前在 ima 知识库这篇文章中使用腾讯的混元模型也测试过这张图,但遗憾的是,混元并没解读出图片更深层的含义。

毫无疑问,Grok3 的图片处理能力也很强。

会话能力#

今天马斯克发文称,将会推出 Grok 的语音模式、记忆功能和其他更多改进。

在之前他公布过一段与 Grok3 对话的录音。

从对话可以听出来,Grok3 有较为丰富的情感,在嘲笑时还会自动配上笑声,说话语调也比较自然。

DeepSeek R1 就不用看了,暂不支持语音功能。

而至于写作能力和数学能力,我测试下来 DeepSeek R1 和 Grok3 都蛮不错的,这里就不展开细说了。

小结#

我们总结下这几项测试结果:

- 推理能力:DeepSeek R1 > Grok3

- 搜索能力:Grok3 > DeepSeek R1

- 代码能力:DeepSeek R1 > Grok3

- 图片处理能力:Grok3 > DeepSeek R1

- 会话能力:Grok3 > DeepSeek R1

从各方面来看,马斯克用 20 万张显卡堆出来的 Grok3 综合实力确实很强,但也没强到马斯克天天吹的各方面都天下第一那样。

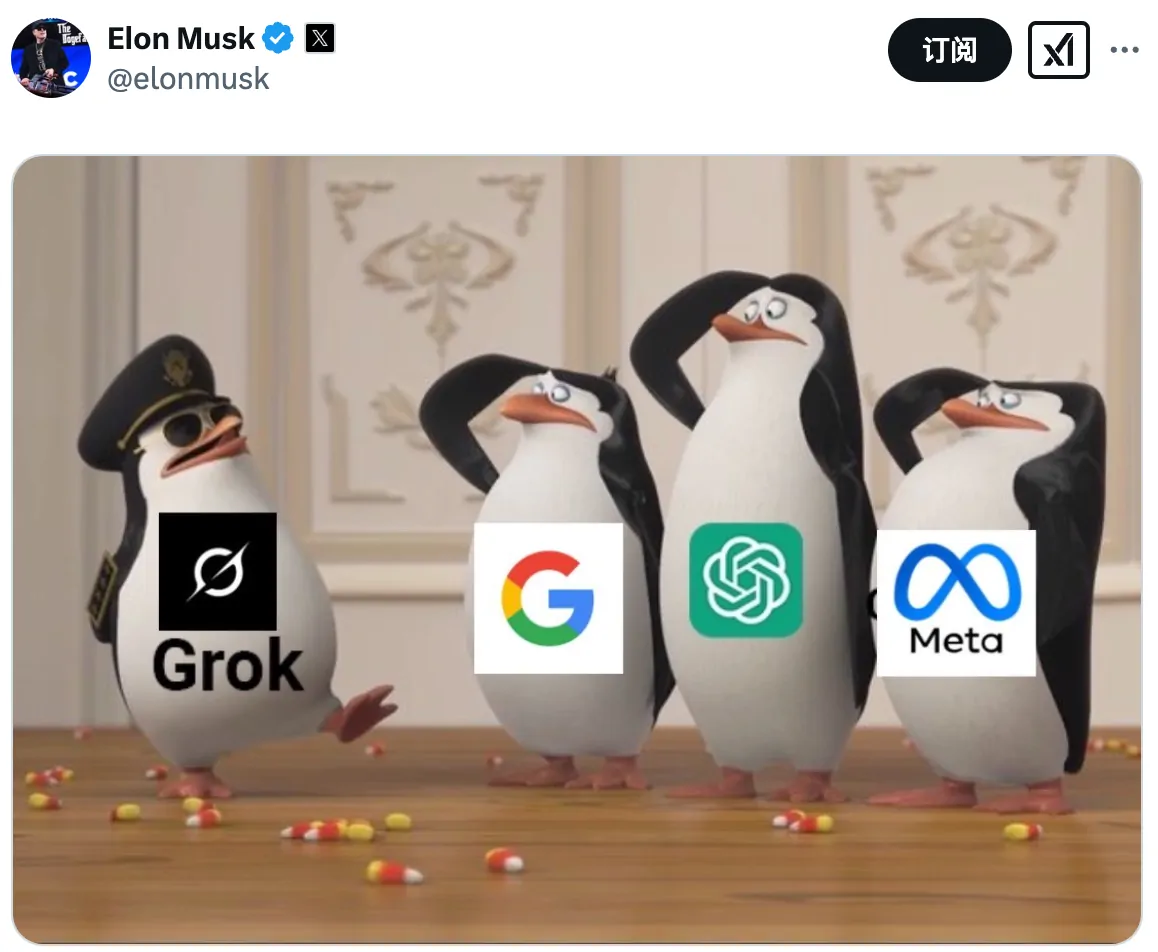

加上马斯克嘲讽 OpenAI 和 Google 等大模型,个人觉得多少有些打脸。。

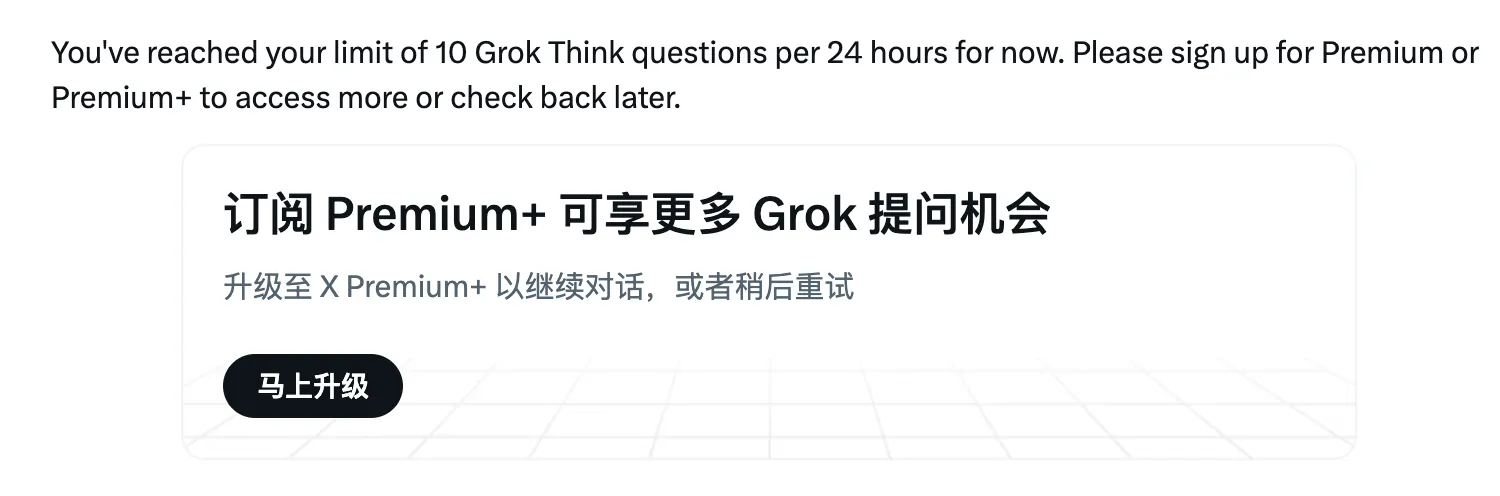

考虑到目前普通用户每天只能使用 Grok3 的 10 次思考功能。

而 DeepSeek R1 并没有这个限制,所以对很多用户来说,DeepSeek R1 的吸引力仍是非常强的。

虽然在马斯克心中,他认为最后将是 xAI 和 Google DeepMind 竞争 AI 龙头老大。

但我仍觉得,DeepSeek R1、阿里的 Qwen 和 Meta 的 Llama 等开源大语言模型也不容小觑。

你觉得呢?